Explorando o Ceph em Redes de Alta Performance: Insights do Benchmark Proxmox VE 2023

- Tiago Morim

- 13 de dez. de 2023

- 4 min de leitura

Atualizado: 23 de mai. de 2024

Vamos mergulhar nos bastidores do armazenamento distribuído, onde discos de alto desempenho e redes cuidadosamente configuradas desvendam o verdadeiro potencial do Ceph.

Os resultados do benchmark conduzido pela Proxmox em dezembro de 2023, com a versão do Proxmox VE 8.0.7 e kernel 6.5.3-1-pve, em conjunto com a versão 18.2.0 "Reef" do Ceph, revelam uma narrativa empolgante envolvendo alto desempenho e resiliência. Este artigo desmistifica e detalha o comportamento da tecnologia, destacando a interseção crítica entre escolhas de hardware inteligentes e o desempenho extraordinário do Ceph.

Navegando nas Redes de 10Gbit/s, 25 Gbit/s e 100 Gbit/s

Redes de 10 Gbit/s

Mesmo com SSDs ultra rápidos, as redes de 10 Gbit/s podem impor limitações inesperadas.

Uma saturação de escrita foi notada em cerca de 1680 MiB/s de escrita enquanto na leitura chega a 4500 MiB/s dependendo da variação da configuração de rede utilizada, apenas informando que essa informação de leitura de 4500 MiB/s não foi disponibilizada nos gráficos da proxmox.

Nos testes realizados, ficou evidente que mesmo SSDs de alto desempenho podem enfrentar obstáculos quando combinados com redes de 10 Gbit/s, reforçando a necessidade de configurações estratégicas para evitar surpresas indesejadas.

Redes de 25 Gbit/s

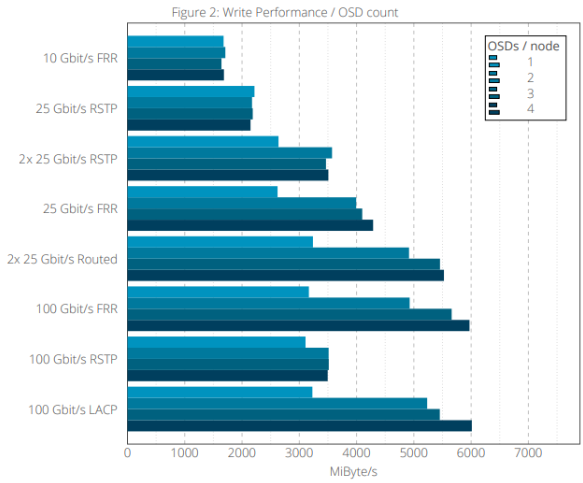

No cenário de redes mais rápidas, as escolhas entre Full-Mesh RSTP¹ e FRR² revelam nuances críticas. Os testes indicam que redes de 25 Gbit/s, especialmente quando configuradas separando as redes públicas e de Ceph tendo um desempenho de até 3500 MiB/s com um uso de dois OSDs por nó, já em uma variação com FRR² as velocidades de escrita chegaram a 4000 MiB/s.

Em termos de leitura as interfaces de 25 Gbit/s iniciam com desempenhos que chegam a 5400 MiB/s e com redes em FRR² chegam a 6400 MiB/s, mas podem performar ainda mais com configurações em round-robin e mais OSDs chegando a 6800 MiB/s.

Redes de 100 Gbit/s

Aqui já podemos encontrar a eficiência superior das redes de 100 Gbit/s, especialmente quando combinadas com discos de alta capacidade. As configurações, como FRR² e LACP³, tornam-se protagonistas nesse palco de desempenho exponencial. Configurações de 100 Gbit/s demonstraram write performance de até 6000 MiB/s e esse parece ser seu limite.

Em testes de leitura 7000 MiB/s com três nós simultâneos é o valor que encontramos nos melhores cenários, destacando o potencial extraordinário dessas redes em ambientes Ceph.

Número de OSDs por Nó e Tipos de Discos

Em ambientes Ceph, a escolha cuidadosa do número de OSDs por nó desempenha um papel crítico na resiliência e recuperação de falhas. Em clusters menores, recomenda-se, no mínimo, um OSD por nó, favorecendo a recuperação de dados em caso de falha. No entanto, a estratégia ideal é optar por quatro OSDs por nó, proporcionando vantagens substanciais.

A distribuição de dados perdidos em caso de falha é eficientemente distribuída entre os OSDs remanescentes, mitigando o risco de sobrecarregar qualquer OSD específico. Essa abordagem, embora ofereça maior resiliência, demanda considerações adicionais sobre os recursos de CPU e memória disponíveis.

Mistura de Discos e Tamanhos

Ao explorar a composição de discos em clusters Ceph, a coerência no hardware é essencial para garantir o máximo desempenho. A incorporação de diferentes tipos ou tamanhos de discos pode impactar significativamente a previsibilidade do desempenho global do cluster.

Embora seja possível, em teoria, misturar discos, a implementação prática requer uma análise cuidadosa para evitar desequilíbrios. A consistência no hardware é crucial para otimizar o desempenho, minimizando assimetrias que podem resultar em gargalos inesperados.

Portanto, ao planejar a composição do cluster Ceph, é prudente manter uma abordagem homogênea em relação aos tipos e tamanhos de discos para garantir um equilíbrio delicado e desempenho previsível. Essa decisão estratégica se alinha aos resultados do benchmark Proxmox VE 2023, destacando a importância da coesão no hardware para otimizar o desempenho do ambiente de armazenamento distribuído.

Performance de Leitura e Escrita

Leitura: Mesmo em clusters modestos, o Ceph atinge até 3400 MiB/s com interfaces de 10 Gbit/s em FRR. Em interfaces 25 Gibt/s encontramos valores entre 4200 Mib/s chegando até 6800 Mib/s com configurações mais robustas de rede. Configurações de 100 Gbit/s podem impulsionar a leitura para 7000 Mib/s aproximadamente. Esses testes são feitos apenas com um cliente por vez.

Escrita: Em redes de 10 Gbit/s temos escrita que chegam a 1680 Mib/s. Em redes 25 Gbit/s com as configurações mais performáticas chegam a 5700 Mib/s que ficam muito similares a interfaces de 100 Gbit/s que atingem 6000 Mib/s em sua melhor performance, de modo que estes testes feitos em um único cliente demonstram a capacidade de escrita para o cliente.

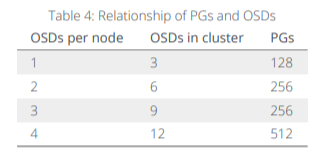

Um único pool Ceph foi utilizado para todos os testes. O número de OSDs determinou a quantidade de grupos de posicionamento (PGs) para o pool durante os testes que foram executados através do iperf.

Além disso, foram usados vários cenários distintos de rede, focando em criar o melhor cenário disponível para cada uma das opções de interface conforme descrito anteriormente.

Para uma leitura mais técnica e aprofundada dos testes, recomendamos a documentação oficial da Proxmox, onde você poderá explorar todos os detalhes dos testes e benchmarks disponibilizados.

Os resultados do benchmark transcendem meros números, revelando narrativas intrincadas de estratégias eficazes. Em resumo podemos identificar uma similaridade muito grande nos testes feitos interfaces de 100 Gbit/s e com 2 interfaces de 25 Gbit/s RSTP em um agregado de 50 Gbit/s, já interfaces 10 Gbit/s demonstram um gargalo que afeta diretamente o Ceph.

Consulte as análises detalhadas do benchmark de dezembro de 2023 da Proxmox para embasar escolhas assertivas e direcionar a evolução do seu ambiente de armazenamento aqui. Essas métricas não são apenas indicadores; são o alicerce para a construção de estratégias robustas e vitoriosas, delineando o caminho preciso para otimizações em um cenário complexo de armazenamento distribuído.

Conceitos:

RSTP, FRR e LACP

RSTP¹ (Rapid Spanning Tree Protocol): Configuração de rede com topologia de loop, apresentando desempenho variável em comparação ao FRR.

FRR² (Full-Mesh Routed): Estratégia de configuração de rede para comunicação eficiente em clusters Ceph, essencial para robustez e resiliência.

LACP³ (Link Aggregation Control Protocol): Tecnologia que combina várias conexões de rede, criando uma interface lógica robusta e balanceada.

Tiago Morim | Gerente de Atendimento e Equipe | NewFront

Ficou interessado em saber mais ? Entre em contato conosco e fale diretamente com um de nossos especialistas.

Comentários